Qué define un dígito Concepto y ejemplos explicados

- El término "dígito", derivado del latín "digĭtus" (dedo), juega un papel crucial en las matemáticas y nuestra vida diaria.

- Indica un número representado por un solo guarismo, como los diez del sistema decimal (0-9), asociados tradicionalmente a los dedos de las manos.

- Más allá del decimal, se exploran otros sistemas como el binario, fundamental en informática por usar solo dos dígitos (0 y 1).

- Este artículo examina la variabilidad y aplicaciones de los dígitos en distintos sistemas numéricos, resaltando su importancia en actividades diarias como operaciones matemáticas y lectura de precios.

- También se delinea su papel en áreas específicas como la informática y en la creación de códigos.

- Finalmente, se abordan errores comunes en la interpretación y conversión entre sistemas numéricos, subrayando el valor de una comprensión sólida de los dígitos en diversas facetas de la vida y la tecnología.

Los dígitos forman el núcleo de los sistemas numéricos, pero su comprensión y aplicaciones van mucho más allá de simples números. En este detallado artículo, desmenuzaremos este fascinante concepto desde sus raíces etimológicas hasta su papel en la informática, pasando por los variados sistemas numéricos y su impacto cotidiano. Prepárate para sumergirte en el mundo de los dígitos, esa parte integral de nuestra vida cotidiana y profesional.

Con una meticulosa atención a los detalles, este artículo te acompañará a través de la importancia de los dígitos, su presencia en diversas disciplinas, y los errores comunes que podrías estar cometiendo al interpretarlos. Es hora de ampliar nuestra comprensión sobre estos componentes cruciales de la matemática y la comunicación.

Definición esencial de dígito

Origen etimológico y concepto

El término "dígito" proviene de la palabra latina "digĭtus", que significa "dedo". Históricamente, los dígitos se relacionaban con los diez dedos de las manos, empleados para contar desde tiempos ancestrales. En el ámbito matemático, un dígito es cualquier cifra entre 0 y 9 en el sistema de numeración decimal, constituyendo la base de este sistema y permitiendo la representación de cualquier número a través de la combinación de estos diez símbolos.

Variaciones en sistemas numéricos

El dígito en el sistema decimal

El sistema decimal, basado en diez símbolos (0-9), es el más empleado a nivel mundial para las actividades cotidianas. Este sistema posicional permite representar números grandes o pequeños de manera eficiente, gracias a la asignación de un valor de posición a cada dígito, multiplicando su valor por potencias de 10 dependiendo de su colocación.

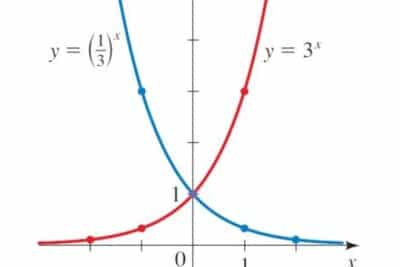

El dígito en el sistema binario

En el sistema binario, sólo se utilizan dos dígitos: 0 y 1. Este sistema es fundamental en la informática y la electrónica, donde cada dígito se conoce como bit. Aquí, la combinación de estos dos únicos símbolos permite representar cualquier número o ejecutar instrucciones complejas en el procesamiento de datos digital.

Otros sistemas numéricos relevantes

Aparte de los sistemas decimal y binario, existen otros como el octal (base 8) y el hexadecimal (base 16) utilizados en contextos específicos de programación y diseño de sistemas digitales. Estos sistemas emplean dígitos extendidos, incluyendo letras del alfabeto para representar valores superiores a 9, demostrando la diversidad y adaptabilidad de los dígitos a diferentes necesidades tecnológicas y científicas.

Importancia de los dígitos en la vida cotidiana

Operaciones matemáticas básicas

Los dígitos son esenciales para realizar operaciones matemáticas básicas como la suma, resta, multiplicación y división. El entendimiento conceptual de cada dígito y su valor posicional es fundamental para desarrollar competencias numéricas desde edades tempranas, permitiendo a las personas calcular presupuestos, entender medidas o seguir recetas.

Lectura de precios y números telefónicos

La capacidad de leer e interpretar dígitos es une elemento imprescanfible en acciones tan cotidianas como comprender precios o memorizar números telefónicos. Esta habilidad nos permite funcionar con eficacia en el mundo moderno, cumpliendo con responsabilidades y manteniendo contactos sociales y profesionales.

Aplicaciones específicas de los dígitos

Los dígitos en la informática

En la informática, los dígitos toman un papel protagonista, especialmente en el sistema binario. La representación digital de datos, el procesamiento de instrucciones en microprocesadores, y la codificación de información para almacenamiento y transmisión, dependen exclusivamente de los dígitos 0 y 1. Este sistema binario es la piedra angular sobre la cual se construye toda la infraestructura informática moderna.

Uso de dígitos en códigos y cifrados

Los dígitos también juegan un papel crucial en la creación de códigos y cifrados, facilitando la seguridad de la información en el ámbito digital. La criptografía, que es el arte de cifrar y descifrar información, utiliza complejas combinaciones de dígitos para proteger datos confidenciales contra el acceso no autorizado, asegurando así la privacidad y la integridad de la información en el ciberespacio.

Errores comunes al interpretar dígitos

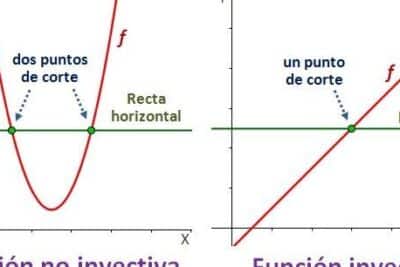

Confusiones en diferentes sistemas numéricos

Una fuente común de errores surge al manejar varios sistemas numéricos simultáneamente. La interpretación equivocada de dígitos en sistemas no decimales, confundiendo sus valores o reglas, puede llevar a cálculos incorrectos, especialmente cuando se trabaja en programación o electrónica, donde el sistema binario, octal o hexadecimal son frecuentemente utilizados.

Errores en la conversión de sistemas

Las dificultades también pueden presentarse durante la conversión entre sistemas numéricos, ya sea por omisiones o errores en el proceso. Estos errores de conversión pueden tener consecuencias graves en entornos que requieren precisa exactitud, como en la programación de software, diseño de circuitos electrónicos o en la interpretación de datos científicos.

Conclusión

Los dígitos son mucho más que simples números. Son la base de nuestro sistema numérico, imprescindibles en la vida cotidiana y piedra angular de la era digital. A través de este análisis exhaustivo, es evidente que comprender los dígitos en toda su extensión, desde su concepto y variaciones en diferentes sistemas, hasta su aplicación y los errores comunes al interpretarlos, es fundamental. No sólo para matemáticos o profesionales de la tecnología, sino para cualquier persona que navegue en el complejo mundo moderno. La próxima vez que escribas un número o presiones una tecla, recuerda el vasto universo que existe detrás de cada dígito utilizado.

Video Relacionado sobre Digito

FAQ Acerca de Digito

¿Qué define exactamente a un dígito?

Un dígito se entiende como un símbolo o carácter numérico que, dentro del sistema de numeración decimal, permite representar cantidades. Este concepto se extiende más allá de simplemente ser números, ya que forma la base de la aritmética y las matemáticas al permitir la construcción de cifras más complejas a partir de su combinación. Por ejemplo, el número 345 está compuesto por tres dígitos: 3, 4 y 5. Cada posición que un dígito ocupa, de derecha a izquierda, indica su valor según potencias de diez debido a la naturaleza del sistema decimal.

¿Cuál es la relación entre dígitos y dedos?

La etimología de la palabra "dígito" nos lleva a su origen en la palabra latina "digĭtus", que se traduce como "dedo". Esta denominación encuentra su razón de ser en la ancestral práctica de contar y realizar operaciones matemáticas simples usando los dedos de las manos. El uso de los dedos como herramientas para contar es un reflejo de la universalidad y la accesibilidad de los conceptos matemáticos básicos, lo que sugiere que, desde tiempos antiguos, la humanidad ha buscado formas concretas y tangibles para entender y manipular conceptos numéricos.

¿Qué sistemas numéricos utilizan dígitos distintos al decimal?

Aparte del familiar sistema decimal, que utiliza los dígitos del 0 al 9, existen otros sistemas numéricos basados en diferentes bases. Por ejemplo, el sistema binario, esencial en el ámbito de la informática, se basa únicamente en dos dígitos: 0 y 1. Cada dígito en este sistema, conocido como bit, es la unidad mínima de datos en computación. Por otro lado, el sistema hexadecimal, utilizado para simplificar la representación binaria en la informática, se compone de 16 dígitos, que incluyen del 0 al 9, seguidos de las letras de la A a la F para representar los valores del 10 al 15.

¿Cómo afecta la comprensión de dígitos en la vida cotidiana?

La comprensión y correcto manejo de los dígitos es fundamental para una vasta gama de actividades cotidianas. Desde realizar transacciones financieras, como calcular precios y presupuestos, hasta seguir recetas de cocina, donde las cantidades de los ingredientes se expresan en unidades numéricas. La habilidad para interpretar y operar con dígitos permite a las personas tomar decisiones informadas, administrar eficazmente sus recursos y resolver problemas prácticos. Este dominio de los dígitos actúa como una herramienta de empoderamiento personal y profesional en un mundo cada vez más cuantificado.

¿Los dígitos tienen diferentes interpretaciones?

Sí, los dígitos pueden tener diferentes interpretaciones según el contexto o el sistema numérico en que se utilicen. Por ejemplo, en el sistema decimal, el dígito "2" simplemente representa el valor dos. Sin embargo, en el sistema binario, el "2" como tal no existe, y los dígitos se limitan a "0" y "1". Además, en el sistema hexadecimal, el dígito "A" representa el número diez, lo que no tiene equivalencia directa en el sistema decimal. Esta variedad de interpretaciones exige una comprensión clara del contexto en que se usan los dígitos para evitar confusiones y errores, especialmente en campos técnicos o especializados como la informática y la ingeniería.

Si quieres conocer otros artículos parecidos a Qué define un dígito Concepto y ejemplos explicados puedes visitar la categoría MATEMÁTICAS.

Deja una respuesta

También te puede interesar: