Bit en Informática: Definición, Concepto Clave y Ejemplos

- En el vasto universo de la informática, el bit ocupa un lugar central como el átomo de la información digital.

- Imagina un mundo donde la comunicación se rige por la simplicidad de los opuestos: sí o no, encendido o apagado.

- En este escenario, el bit emerge como el protagonista, una entidad capaz de capturar la esencia de esta dicotomía mediante su capacidad para adoptar uno de dos valores posibles: 0 o 1.

- Este diminuto gigante de la informática no solo simplifica el complejo lenguaje de las máquinas a través del sistema binario, sino que también establece las bases para la creación, almacenamiento y procesamiento de todo tipo de datos digitales.

La belleza de los bits radica en su colectividad; individualmente representan las opciones más básicas, pero en conjunto, despliegan un abanico de posibilidades casi infinito.

- Un par de estos elementos puede codificar cuatro estados distintos, multiplicando exponencialmente su potencial con cada adición.

- Desde la reproducción de textos en un documento hasta la complejidad de las imágenes en alta definición y los sonidos en nuestras canciones favoritas, los bits son los incesantes trabajadores detrás de la cortina de nuestros dispositivos digitales.

Más allá de su utilidad práctica en la representación de datos, los bits encarnan el principio fundamental de la computación: la transformación de la compleja realidad en un lenguaje binario que las máquinas pueden entender y procesar.

- Al adentrarnos en el concepto de bit, nos sumergimos en la esencia misma de la tecnología digital, desentrañando el misterio de cómo se articulan, almacenan y transmiten las vastas constelaciones de información que definen nuestro mundo conectado.

El avance de la tecnología ha transformado nuestra sociedad a lo largo de las décadas, y uno de los elementos fundamentales en esta transformación es el bit en informática. Exploraremos en detalle qué es un bit, su origen, su importancia y cómo se utiliza en el mundo de la informática. Además, analizaremos ejemplos concretos de su aplicación en diferentes contextos y reflexionaremos sobre su futuro en el campo tecnológico. ¡Descubramos juntos el fascinante mundo de los bits en informática!

¿Qué es un bit en informática?

El bit, acrónimo de "binary digit" o "dígito binario" en español, es la unidad básica de información en el campo de la informática. Consta de dos posibles valores: 0 o 1, lo que lo convierte en un componente esencial para la representación y el procesamiento de datos digitales. Mientras que en el sistema decimal utilizamos diez dígitos (del 0 al 9), en el sistema binario solo utilizamos dos dígitos: 0 y 1. Estos valores binarios se utilizan para transmitir y almacenar información en los dispositivos electrónicos.

Origen del término bit

El término "bit" fue acuñado en 1948 por el matemático estadounidense Claude Elwood Shannon, considerado el padre de la teoría de la información. El nombre surge de la contracción de las palabras "binary digit" y fue utilizado por primera vez en un artículo publicado en el famoso Journal of Electrical Engineering. Desde entonces, el término "bit" se ha popularizado y se ha convertido en una parte integral del lenguaje de la informática.

Bits vs. Bytes: Diferencias fundamentales

Es importante distinguir entre los conceptos de "bit" y "byte", ya que a menudo se utilizan de manera intercambiable pero tienen significados diferentes. Mientras que un bit representa la unidad más pequeña de información, un byte es un grupo de 8 bits que generalmente se utiliza para representar un único carácter o símbolo en un sistema de codificación. En otras palabras, un byte es una secuencia de 8 bits que se considera una unidad de datos más significativa. Por lo tanto, podemos decir que un byte es equivalente a 8 bits.

Funcionamiento y uso de los bits

Ahora que hemos establecido la definición de un bit, es importante entender cómo funcionan y cómo se utilizan en el ámbito de la informática. Los bits son la base de la codificación de información en el sistema binario, que es ampliamente utilizado en las computadoras y otros dispositivos electrónicos. A través de combinaciones de bits, es posible representar y manipular textos, imágenes, sonidos y cualquier tipo de dato digital.

Codificación binaria en la informática

La codificación binaria es un método de representación de información utilizando solo dos símbolos, 0 y 1. Cada símbolo, o bit, en un número binario representa una posición o lugar en una secuencia numérica. Por ejemplo, un número binario de 8 bits puede representar un valor que varía desde 00000000 hasta 11111111, lo que en el sistema decimal equivale a los números del 0 al 255. Esta codificación binaria es la base para el procesamiento de datos en los sistemas informáticos.

Importancia de los bits en el almacenamiento

Los bits también juegan un papel crucial en el almacenamiento de datos en los dispositivos informáticos. La unidad básica de almacenamiento es el bit, y múltiples bits se agrupan para formar unidades de almacenamiento más grandes, como los bytes, kilobytes, megabytes, gigabytes y terabytes. Estas unidades de almacenamiento se utilizan para medir la capacidad de almacenamiento de dispositivos como discos duros, memorias USB y tarjetas de memoria. Cuanto mayor sea el número de bits almacenados, mayor será la capacidad para guardar información.

Aplicaciones prácticas de los bits

Ahora que hemos comprendido cómo funcionan y se utilizan los bits, demos un paso más y exploremos algunas aplicaciones prácticas de los bits en el mundo de la informática.

Bits en la transmisión de datos

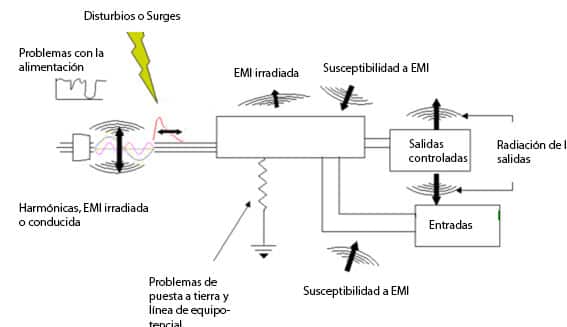

Los bits son fundamentales en la transmisión de datos a través de redes de computadoras. Cuando enviamos información de un dispositivo a otro, esta información se descompone en secuencias de bits que viajan a través de cables u ondas de radio. La velocidad de transferencia de datos se mide en bits por segundo (bps) y es uno de los factores clave para determinar la rapidez con la que podemos transmitir información.

Representación de colores y gráficos

La representación de colores y gráficos en los dispositivos electrónicos también se basa en los bits. Cada píxel de una imagen en una pantalla, por ejemplo, se compone de una combinación de bits que representa el color de ese píxel. Cuantos más bits se utilicen para representar un píxel, mayor será la precisión del color y la calidad de la imagen. Por eso, en una imagen digital, podemos encontrar valores como 8 bits por canal (RGB), 16 bits por canal (RGB), entre otros.

Ejemplos ilustrativos sobre el uso de bits

Ahora analicemos algunos ejemplos concretos para comprender mejor cómo se utilizan los bits en diferentes contextos.

Bits en sistemas de cifrado

En los sistemas de cifrado, los bits desempeñan un papel fundamental para garantizar la seguridad de la información. Los algoritmos de cifrado utilizan los bits para transformar los datos originales en una forma ilegible, y solo aquellos que conocen la clave correcta pueden decodificar la información. Cuanto mayor sea el número de bits utilizados en un cifrado, mayor será la dificultad para descifrar los datos sin la clave adecuada.

Cómo los bits definen la calidad de audio

La calidad del audio también depende del uso de bits en su representación digital. Cuanto mayor sea el número de bits utilizados para representar una señal de audio, mayor será la precisión y la calidad del sonido producido. Por ejemplo, en la música digital, se utilizan diferentes resoluciones de bits para representar la amplitud de las ondas de sonido y, por lo tanto, lograr un sonido más claro y de mayor fidelidad.

El futuro de los bits en la tecnología

Con la constante evolución de la tecnología, es interesante pensar en cómo evolucionarán los bits en el futuro y qué impacto tendrán en el campo de la informática.

Impacto de la computación cuántica en el bit

Uno de los avances más prometedores en la informática es la computación cuántica, que utiliza los principios de la física cuántica para realizar cálculos mucho más rápidos y eficientes que los sistemas actuales. En la computación cuántica, los bits tradicionales (0 y 1) son reemplazados por qubits, que pueden representar múltiples estados simultáneos gracias al fenómeno de la superposición cuántica. Esto abre la puerta a nuevas formas de procesamiento de datos e introduce conceptos como la entrelazación y la teleportación cuántica.

Los bits son la base de la información digital y juegan un papel fundamental en la informática moderna. Su utilización en la codificación, transmisión y almacenamiento de datos ha revolucionado nuestra forma de comunicarnos, crear y compartir información. A medida que avanzamos hacia la era de la computación cuántica, es emocionante imaginar cómo los bits seguirán evolucionando y definiendo el futuro de la tecnología.

Video sobre Bit

Preguntas Frecuentes sobre Bit

¿Cómo se relacionan los bits con los bytes?

Los bits y los bytes son unidades de medida fundamentales en el mundo de la informática, pero cumplen roles diferentes y se relacionan entre sí de manera específica. Un bit, como la unidad mínima de información, puede representar dos valores (0 o 1). Por otro lado, un byte está compuesto por un conjunto de 8 bits. Esta agrupación permite representar una gama más amplia de información, como un carácter alfanumérico o un símbolo especial en la codificación de texto ASCII, por ejemplo.

La relación entre bits y bytes es crucial para entender cómo se mide y almacena la información digitalmente. Cada byte, al tener 8 bits, puede representar 256 combinaciones diferentes (2^8), permitiendo codificar un rango extenso de caracteres o instrucciones. Esta estructura es la base sobre la que se construyen archivos, programas y todo tipo de datos en los sistemas informáticos actuales, desde el más simple documento de texto hasta complejas aplicaciones y sistemas operativos.

¿Por qué el bit es tan importante en la computación?

El bit es la piedra angular de la computación; su importancia radica en su simplicidad y versatilidad. Al operar bajo un sistema binario que solo maneja dos estados posibles (0 y 1), los bits hacen posible la representación, procesamiento y almacenamiento eficiente de la información en dispositivos electrónicos. Este sistema binario, basado en bits, permite codificar cualquier tipo de datos, desde textos y números hasta imágenes y sonidos, en patrones digitales que pueden ser fácilmente gestionados por las computadoras.

Los bits también son cruciales para la elaboración de operaciones lógicas y aritméticas en los procesadores, facilitando la toma de decisiones y el cálculo computacional a velocidades extremadamente altas. La capacidad para manipular bits y su representación en estructuras más complejas, como bytes y palabras, es lo que hace posible la creación de software que puede llevar a cabo tareas diversas y complicadas, desde navegar por internet hasta realizar simulaciones científicas avanzadas.

¿Qué papel juegan los bits en la codificación de datos?

Los bits juegan un papel esencial en la codificación de datos, siendo los bloques constructivos primarios sobre los cuales se construye toda representación digital. La codificación de datos, sea en forma de texto, números, imágenes o sonidos, empieza con la conversión de estas informaciones a una secuencia binaria de bits.

Por ejemplo, en la codificación de texto bajo el estándar ASCII, cada letra, número o símbolo se asocia a un valor específico representado por una combinación de 8 bits (un byte). De manera similar, en el ámbito de la representación de imágenes digitales, cada bit puede influir en la coloración de un píxel específico en la imagen, determinando así la visualización final de la misma.

Además, en el procesamiento de señales digitales, como el audio y el vídeo, los bits permiten una discretización del continuo de las señales analógicas en valores digitales que pueden ser almacenados, procesados y transmitidos eficientemente por medios digitales. Estas capacidades hacen de los bits elementos indispensable en la codificación y gestión de datos en la era digital.

¿Los bits tienen el mismo rol en todas las tecnologías?

Aunque el bit es una constante en el núcleo de cualquier tecnología digital, su papel puede variar significativamente dependiendo del contexto tecnológico específico. En todos los casos, los bits constituyen la unidad básica de información, pero la forma en que se organizan, procesan y utilizan puede cambiar drásticamente de una tecnología a otra.

En la computación, los bits son fundamentales para representar datos y ejecutar instrucciones dentro de los procesadores. En telecomunicaciones, los bits se utilizan para codificar y transmitir información a través de diferentes medios, siendo la eficiencia y velocidad de transmisión de estos datos digitales un área de interés principal. En la tecnología de almacenamiento, la densidad y la rapide smarte de acceso a bits almacenados definen la capacidad y desempeño de dispositivos de almacenamiento.

Además, con el advenimiento de nuevas tecnologías, como la cuántica, el concepto del bit evoluciona hacia unidades de información más complejas, como el qubit, que representa estados mucho más complejos que los simples 0s y 1s. Esto ilustra cómo, aunque el principio fundamental del bit como unidad de información permanece constante, su aplicación y significado pueden transformarse considerablemente de acuerdo con los avances tecnológicos.

¿Existe alguna limitación en el uso de bits?

Las limitaciones en el uso de bits generalmente surgen de las restricciones físicas y técnicas de los dispositivos que los manipulan y almacenan. A nivel más fundamental, la cantidad de bits que se puede procesar o almacenar en un espacio dado está limitada por la miniaturización de los componentes electrónicos y la eficiencia de los algoritmos y arquitecturas informáticas. A medida que la tecnología avanza, estas limitaciones se han ido superando gradualmente mediante el desarrollo de procedimientos más eficientes y la creación de nuevos materiales y técnicas de fabricación, permitiendo incrementar la densidad de información (bits por unidad de área) en los dispositivos de almacenamiento y mejorar las capacidades de procesamiento en los microprocesadores.

Otra limitación importante se refiere al ancho de banda y retardos en la transmisión de bits a través de redes de comunicación. A pesar de los avances significativos en tecnologías de comunicación, la cantidad de datos que puede ser transmitida en un periodo dado y la velocidad a la que estos datos viajan pueden verse limitadas por la capacidad de la infraestructura de red disponible y las condiciones del medio de transmisión.

En el contexto de la seguridad, la representación binaria de la información y su transmisión plantean desafíos en términos de encriptación y protección contra accesos no autorizados o alteraciones, siendo la robustez de los esquemas de encriptación y la integridad de los datos preocupaciones constantes en la gestión de bits.

Si quieres conocer otros artículos parecidos a Bit en Informática: Definición, Concepto Clave y Ejemplos puedes visitar la categoría CIENCIAS.

Deja una respuesta

También te puede interesar: